L’internet des objets a besoin de standards

L’internet des objets, le X internet, le tout internet … de nombreux termes pour annoncer l’avènement d’une nouvelle génération internet dominée par les objets connectés et les échanges de données Machine to Machine. Mais alors que les gens sont de plus en plus enthousiastes à propos des objets qui par exemple permettent de rester en forme (fitbit, runkeeper, withings etc.), une récente étude Forrester note que ces applications restent limitées car elles ne peuvent pas encore communiquer entre elles.

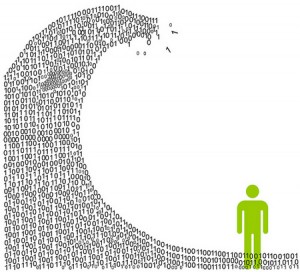

Certains systèmes peuvent mesurer l’activité physique, d’autres les techniques sportives, et beaucoup d’autres encore les données biométriques. Le résultat est un réservoir de données regroupées en silos, toutes reliées à leur application propre. Mais les entreprises qui les commercialisent pourront se rapprocher de leurs clients uniquement lorsqu’ils seront en capacité de regrouper toutes ces données dans un système unique. L’étude préconise d’intégrer les applications CRM, les systèmes d’inventaire, les parcours d’achats clients et leur expérience. A ce moment-là seulement on pourra parler de l’internet « intelligent » des objets.