Si les algorithmes savent tout, à quoi servent les humains ?

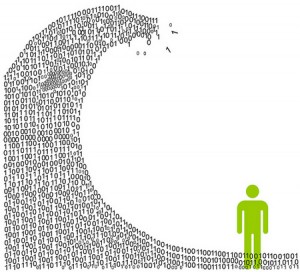

Les plus grands scientifiques et ingénieurs en nouvelles technologies se consacrent à l’optimisation du marketing et du commerce. L’ère d’internet, l’abondance des données, et les applications intelligentes ont ouverts la porte au marketing, à la publicité ciblée, et à la recommandation personnalisée de produits ou services.

La prise de décision automatisée est censée soulager les humains, mais il est aussi très humain de vouloir vérifier ces résultats générés par l’ordinateur. Certains voient le marketing comme un laboratoire d’essai pour faire émerger une science. Car dans le cas où un algorithme est faux, la conséquence n’est pas catastrophique : une audience voit juste une publicité non adaptée pour elle.